Vous en avez marre d’être surveillé et censuré quand vous parcourez le web ? Vous rêvez d’accéder à tous les contenus que vous souhaitez sans que personne ne vienne fouiner dans vos affaires ? Alors, laissez-moi vous présenter Outline VPN, le logiciel libre et open source qui va transformer votre expérience en ligne !

Cette solution utilise un protocole discret et difficile à détecter, vous permettant ainsi de contourner les restrictions des censeurs. Ainsi, vous pourrez naviguer incognito et accéder à tous vos sites préférés, même ceux habituellement bloqués dans votre cher pays.

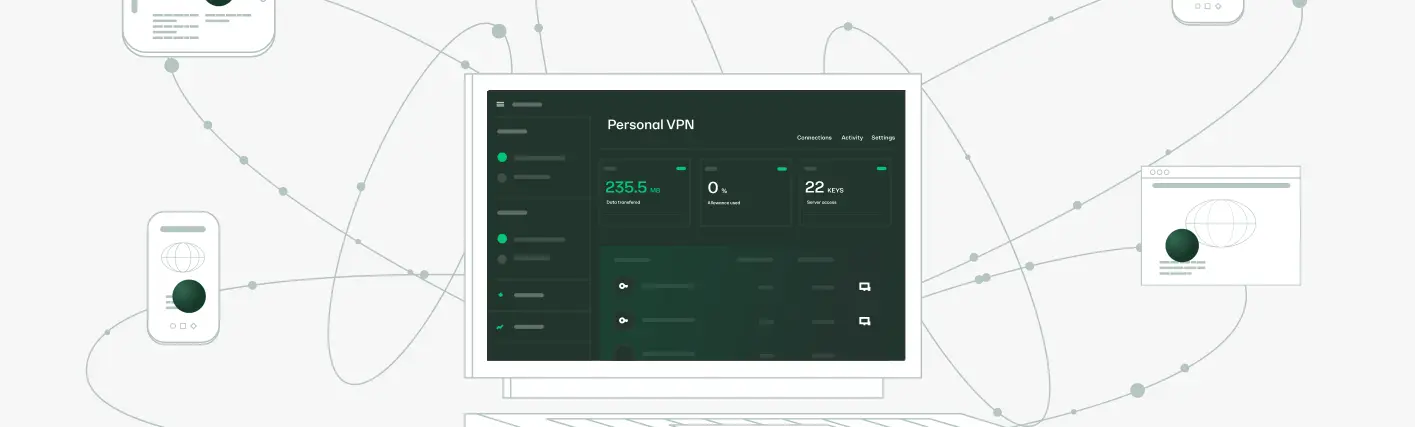

Mais ce n’est pas tout puisque Outline vous offre la possibilité de créer votre propre serveur VPN en quelques clics, et de le partager avec vos amis. Ainsi, vous disposez de votre propre réseau privé, où vous pouvez échanger en toute tranquillité loin des regards indiscrets.

Et si jamais votre serveur est repéré et bloqué par ceux qui n’apprécient pas votre amour de la liberté, ne vous inquiétez pas car avec cet outil, vous allez pouvoir le recréer facilement et rapidement. Evidemment, côté sécurité et confidentialité, Outline assure… Le code a été audité par des sociétés indépendantes, telles que Radically Open Security en mars 2018 et décembre 2022, ainsi que Cure53 en décembre 2018, qui ont confirmé que vos données sont protégées et que votre activité en ligne n’est pas enregistrée. Bref, une fois en place, vous pouvez surfer l’esprit tranquille, personne ne viendra fouiner dans votre historique.

Voici un guide étape par étape pour vous lancer :

Il faut savoir avant tout que Outline se compose de deux produits interdépendants qui fonctionnent ensemble pour vous fournir, à vous et votre communauté, un accès sans interruption à Internet.

Etape 1 : L’installation

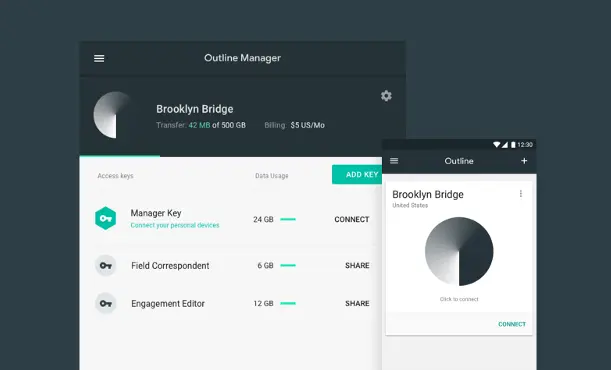

Téléchargez Outline Manager, l’application en version desktop pour Windows, Linux et macOS, qui vous permettra de configurer votre serveur en quelques clics. Vous pourrez ainsi gérer tous les aspects de votre serveur de manière centralisée et choisir parmi une liste de fournisseurs de services cloud de confiance (Google, Amazon, Digital Ocean…) ou utiliser votre propre infrastructure sous Linux pour le déployer.

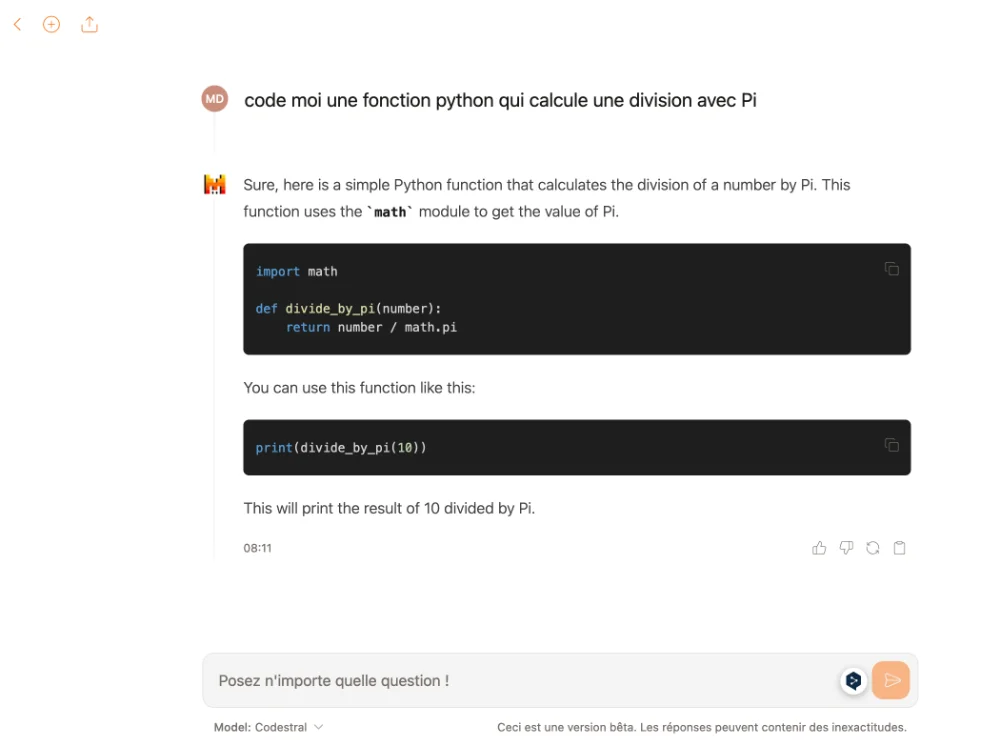

Etape 2 : Générez des clés d’accès

Après avoir configuré votre serveur, vous devez générer des clés d’accès uniques directement à partir de l’application Desktop. Vous pourrez alors envoyer des invitations à vos amis et les clés d’accès leur permettront de connecter leurs appareils (et le votre) à votre serveur Outline. Chaque clé est gérée individuellement et peut être limitée en termes de bande passante pour éviter qu’un utilisateur ne consomme toutes les ressources.

Etape 3 : Téléchargez l’appli du client Outline sur PC / Mac et smartphone

Ensuite l’application Outline à partir de l’App Store ou de Google Play Store, et connectez-vous à l’aide de votre clé d’accès unique.

Et bonne nouvelle si vous êtes développeur, le SDK Outline offre une bibliothèque et un ensemble d’outils multiplateformes permettant aux codeurs d’applications d’intégrer les stratégies avancées de mise en réseau d’Outline pour limiter les interférences réseau les plus complexes.

Bref, ça peut servir… A tester en tout cas.

Merci à Lorenper pour l’info sur cet outil !